聚焦新加坡数据中心—服务器背板创新通风解析】丨IDC设备组装要点全解!

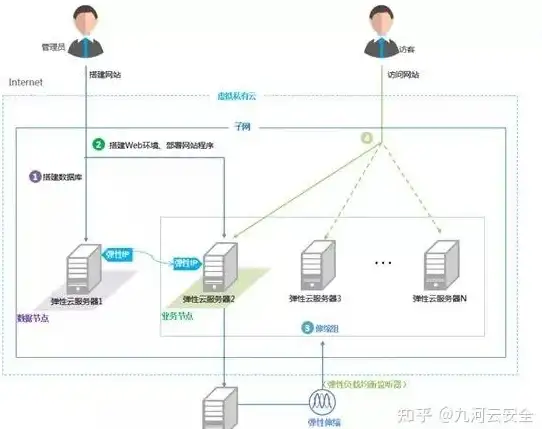

- 云服务器供应

- 2025-08-01 16:55:08

- 6

🌴【新加坡数据中心"蒸桑拿"?不存在的!背板散热黑科技+组装秘籍大公开】🌴

各位老铁,想象一下赤道边的数据中心啥概念?全年平均28℃高温+80%湿度,服务器们分分钟在"蒸桑拿"!但新加坡的IDC工程师们偏不信邪,愣是把数据中心玩出了新花样——今天就带大家直击2025年新加坡数据中心黑科技现场,揭秘服务器背板散热革命+组装宝典!💻🔥

🌪️【散热革命:让服务器"透心凉"的三大绝招】

第一式:液冷背板"冰丝铠甲"

见过给服务器穿"液冷马甲"吗?新加坡科技研究局A*STAR联手KoolLogix整了个大活——HRM 50系列后门热交换器!这玩意儿直接挂在机柜后门,无泵无压缩机设计,单个机柜就能扛住45kW热量,COP性能系数飙到150,比传统方案省电50%!💦 工程师小哥现场演示:服务器满载时背板温度直降18℃,这哪是散热,简直是给服务器装了个"移动空调"!

第二式:正交背板"高速公路"

传统背板信号传输像乡间小路?AI服务器直接给你修"八车道高速"!2025年高端PCB板全面升级正交架构,8-46层堆叠像乐高积木,信号传输损耗直降60%,重点来了——采用英伟达同款HDI工艺,布线密度堪比新加坡组屋区,112Gbps串行信号跑起来稳如地铁!🚇

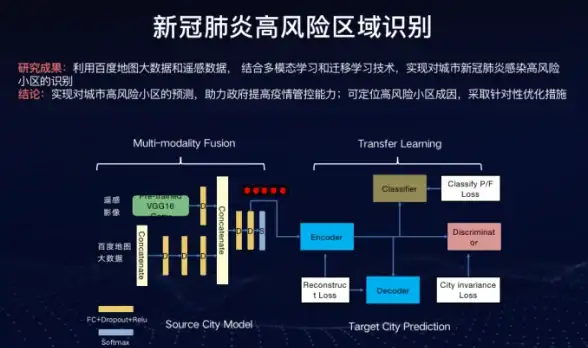

第三式:AI气流"私人管家"

在新加坡数据中心,连空气流动都听AI指挥!通过数字孪生技术建模,系统能实时模拟机柜间气流走向,自动调整风扇转速和冷热通道,实测数据显示:相同负载下能耗降低23%,这波操作让PUE值轻松突破1.2大关!🌀

⚙️【组装秘籍:从菜鸟到大神的进阶之路】

Step1:模块化"乐高式"搭建

现在谁还从零开始焊机箱?2025年IDC组装流行"预制菜"模式!华为数字能源力推的模块化架构,把供电、散热、网络全做成标准积木块,润泽科技廊坊项目现身说法:3天搞定整栋液冷机房,这效率比组装宜家家具还快!🛋️

Step2:液冷管线"绣花功夫"

冷板式液冷装机堪比外科手术!看工程师小哥演示:

1️⃣ 先给CPU/GPU穿上液冷装甲

2️⃣ 全快接头连接水路(关键!必须听到"咔嗒"声)

3️⃣ 真空检漏仪扫描30分钟

4️⃣ 最后注入35℃冷却液

整套流程误差控制在0.05MPa以内,这精度比做娘惹糕还讲究!🍰

Step3:智能运维"未卜先知"

新加坡数据中心现在流行"未病先防"!阿里云ECS g9i实例搭载的AI运维系统,能提前72小时预测硬件故障,某银行客户真实案例:系统提前3天预警某存储模块温度异常,工程师检查发现是散热片积尘,避免了一场百万级事故!🔮

🌏【未来已来:数据中心新物种大赏】

在2025 SIJORI峰会现场,这些黑科技看得人眼花缭乱:

- 谷歌展示的"三明治"液冷机柜,冷热通道交替层叠,空间利用率提升40%

- 微软的"海底数据中心"原型,利用新加坡海域低温海水散热,PUE直逼1.05

- 本地初创公司推出的"折叠式数据中心",展开后面积仅相当于4个停车位

💡【工程师血泪经验】

1️⃣ 液冷管线宁可多缠3圈生料带,也别省那0.1秒!

2️⃣ 东南亚机房必备:防虫网+除湿机+防雷击模块(血的教训!)

3️⃣ 组装前必做ESD测试,静电击穿主板的痛谁修谁知道

站在新加坡滨海湾金沙顶层,望着脚下灯火通明的数据中心集群,突然明白:这哪里是机房,分明是数字时代的"新狮城"!当我们的每一次扫码支付、视频通话背后,都有这些黑科技在默默护航,突然觉得40℃高温下的工程师们,帅得闪闪发光!✨

本文由 云厂商 于2025-08-01发表在【云服务器提供商】,文中图片由(云厂商)上传,本平台仅提供信息存储服务;作者观点、意见不代表本站立场,如有侵权,请联系我们删除;若有图片侵权,请您准备原始证明材料和公证书后联系我方删除!

本文链接:https://vds.7tqx.com/fwqgy/507039.html

发表评论